IIR17章まとめ

16章で、フラットクラスタリングについてまとめたのに引き続き、17章では階層的クラスタリングについて説明する。

階層的クラスタリングとは、以下のような階層を自動的に作り出すことである。

HAC

HAC(Hierarchical Agglomerative Clustering)は、ボトムアップな階層的クラスタリング手法である。

HACでは、まずドキュメントの数だけクラスタを作成し、類似クラスタをマージしながら、最終的に1つのクラスタにする。

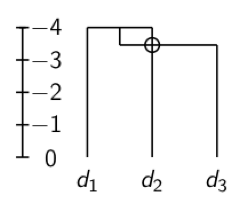

これを表現するのに、以下のようなデンドログラムを用いる。

デンドログラムの断面でクラスタが得られる。(上図では0.1,0.4でカットしている)

そして、どのように類似度を定義するかがキーとなるが、それには様々な決め方がある。

最短距離法(Single-link)

すべてのドキュメントの組み合わせに関して距離を求め、最も近い距離をクラスタ間の距離とする。

計算量は。

最長距離法(Complete-link)

すべてのドキュメントの組み合わせに関して距離を求め、最も近い距離をクラスタ間の距離とする。

計算量は。